El acelerador GH200 de Nvidia entra en producción

hace 9 meses

Nvidia ha confirmado que su chip GH200 que combina CPU y GPU está en producción. Estará en el centro de los sistemas DGX H200, que están destinados a entrenar grandes modelos de datos, en particular para IA generativas.

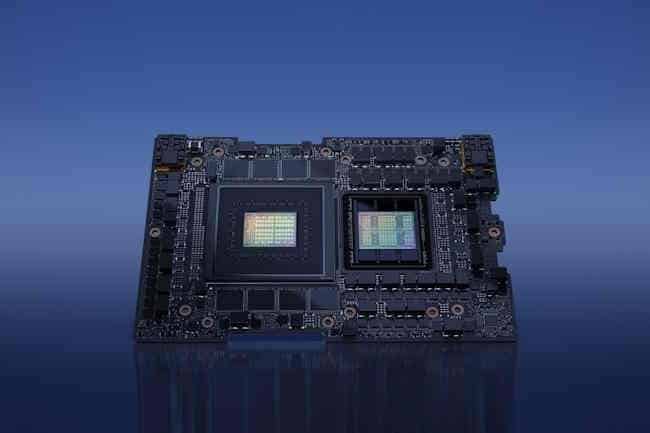

Nvidia no pierde el tiempo. Dos meses después de presentar DGX Cloud y sus sistemas DGX H100 basados en acelerador H100, el proveedor estadounidense aprovecha la conferencia Computex 2023 en Taiwán para dar noticias de su último chip GH200 orientado a HPC y procesamiento de IA a gran escala. Ahora en producción y esperado para fin de año, combina una CPU Grace y una GPU Hopper H100 (Grace Hopper es un guiño a uno de los científicos informáticos más reconocidos).

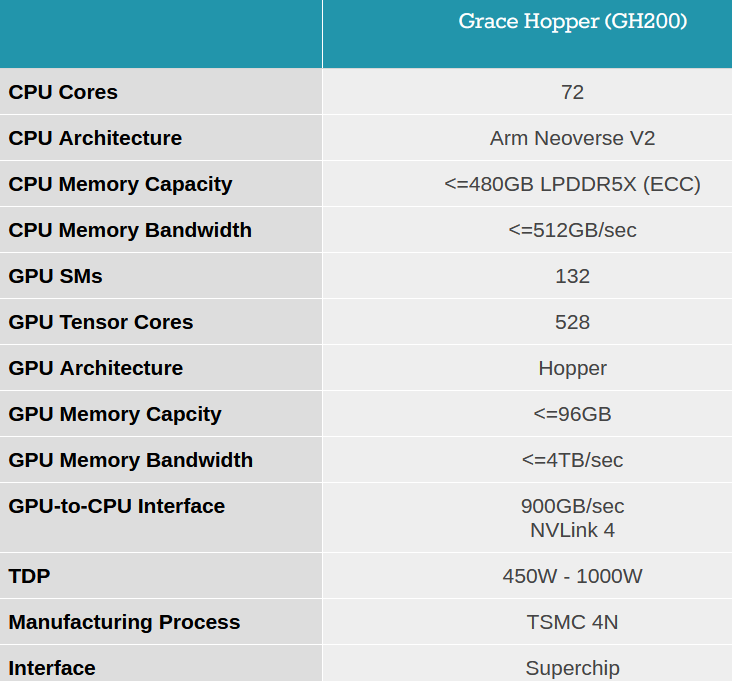

Por el lado de la CPU, se optó por una arquitectura Arm Neoverse V2 con 72 núcleos y viene con memoria LPDDR5X de hasta 480 GB. Con el acelerador H100, el sistema tiene una interconexión mucho más rápida que una configuración tradicional de CPU + GPU basada en PCIe. El enlace NVLink-C2C promete un ancho de banda de 900 GB/s entre los dos chips (450 GB/s en cada dirección). Nvidia señala que esta velocidad es 7 veces superior a la de PCIe Gen5 por 5 veces menos de consumo. En total, el sistema DGX GH200 incluirá hasta 256 GH200, 144 TB de memoria y una capacidad de procesamiento teórica de 1 exaflops.

Las características del chip GH200 de Nvidia. (Crédito de la foto: Nvidia)

Diseños de referencia DGX GH200 para GAFAM

Nvidia anuncia que su sistema GH200 se integrará en su supercomputadora Helios, que combinará 4 DGX GH200 interconectados mediante la tecnología de red Quantum-2 Infiniband de Nvidia, incorporando no menos de 1024 chips GH200 cuando se ponga en servicio a finales de año. Los socios de Nvidia también planean crear sus propios sistemas basados en el GH 200, comenzando con Quanta Computer con su S74G-2U lanzado en 2023. Pero no está solo ya que Asus, Cisco, Dell Technologies, Gigabyte Technology, HPE, Inventec y Pegatron Corp. se encuentran entre los proveedores asociados.

Un clúster DGX GH200 puede ofrecer hasta 1 exaflops de procesamiento para entrenar los modelos de big data de IA generativa. (Crédito de la foto: Nvidia)

“La IA generativa está transformando rápidamente los negocios, desbloqueando nuevas oportunidades y acelerando los descubrimientos en el cuidado de la salud, las finanzas, los servicios comerciales y muchas otras industrias”, dijo Ian Buck, vicepresidente de la división de Computación Acelerada de Nvidia. “Con los chips Grace Hopper en plena producción, los fabricantes de todo el mundo pronto proporcionarán la infraestructura acelerada que las empresas necesitan para construir e implementar aplicaciones de inteligencia artificial generativa que aprovechen sus datos patentados”. Los primeros clientes finales de Nvidia son, como era de esperar, grandes consumidores de IA generativa. Así, entre las primeras empresas interesadas encontramos Google Cloud, Meta o Microsoft. Nvidia también planea proporcionar su DGX GH200 como modelo de referencia para los proveedores de servicios en la nube que deseen adaptarlo a su propia infraestructura. “Tradicionalmente, el entrenamiento de grandes modelos de IA ha sido una tarea que consume mucho tiempo y recursos”, dijo Girish Bablani, vicepresidente del negocio de infraestructura Azure de Microsoft. "La capacidad del DGX GH200 para trabajar con conjuntos de datos a escala de terabytes permitiría a los desarrolladores realizar investigaciones avanzadas a mayor escala y a velocidades aceleradas".

Software de gestión de IA específico respaldado por sistemas DGX GH200

"Las supercomputadoras DGX GH200 AI integran las tecnologías de red y computación acelerada más avanzadas de Nvidia para impulsar las fronteras de la IA", dijo Jen-Hsun Huang, CEO de Nvidia. Las supercomputadoras DGX GH200 AI también contarán con software para ejecutar cargas de trabajo de análisis de datos e inteligencia artificial, incluido Base Command, que proporciona administración de cargas de trabajo, clústeres y bibliotecas de inteligencia artificial. Una capa de software de más de 100 marcos de IA, modelos previamente entrenados y herramientas de desarrollo para agilizar la producción de IA generativa, visión artificial, IA de voz y otros tipos de modelos también forman parte del núcleo. programa.

Si quieres conocer otros artículos parecidos a El acelerador GH200 de Nvidia entra en producción puedes visitar la categoría Otros.

Otras noticias que te pueden interesar