GTC 2021: Nvidia se centra en el centro de datos

hace 3 años

Desde el alquiler de equipos HPC hasta herramientas para acelerar la IA, Nvidia celebró un GTC 2021 en un modo virtual particularmente denso. El proveedor de soluciones de HPC y aceleración de gráficos se inclina cada vez más hacia el centro de datos.

Con unas pocas docenas de comunicados de prensa y publicaciones de blogs combinados, nadie puede decir que la Conferencia de Tecnología GPU (GTC) de Nvidia sea un asunto modesto. Al igual que el año pasado, tuvo lugar en modo virtual debido a la pandemia, por lo que muchos anuncios provienen de la cocina del CEO Jen-Hsun Huang. Aquí hay un resumen de los más relevantes para los operadores de centros de datos.

Dos versiones del Ampère 100

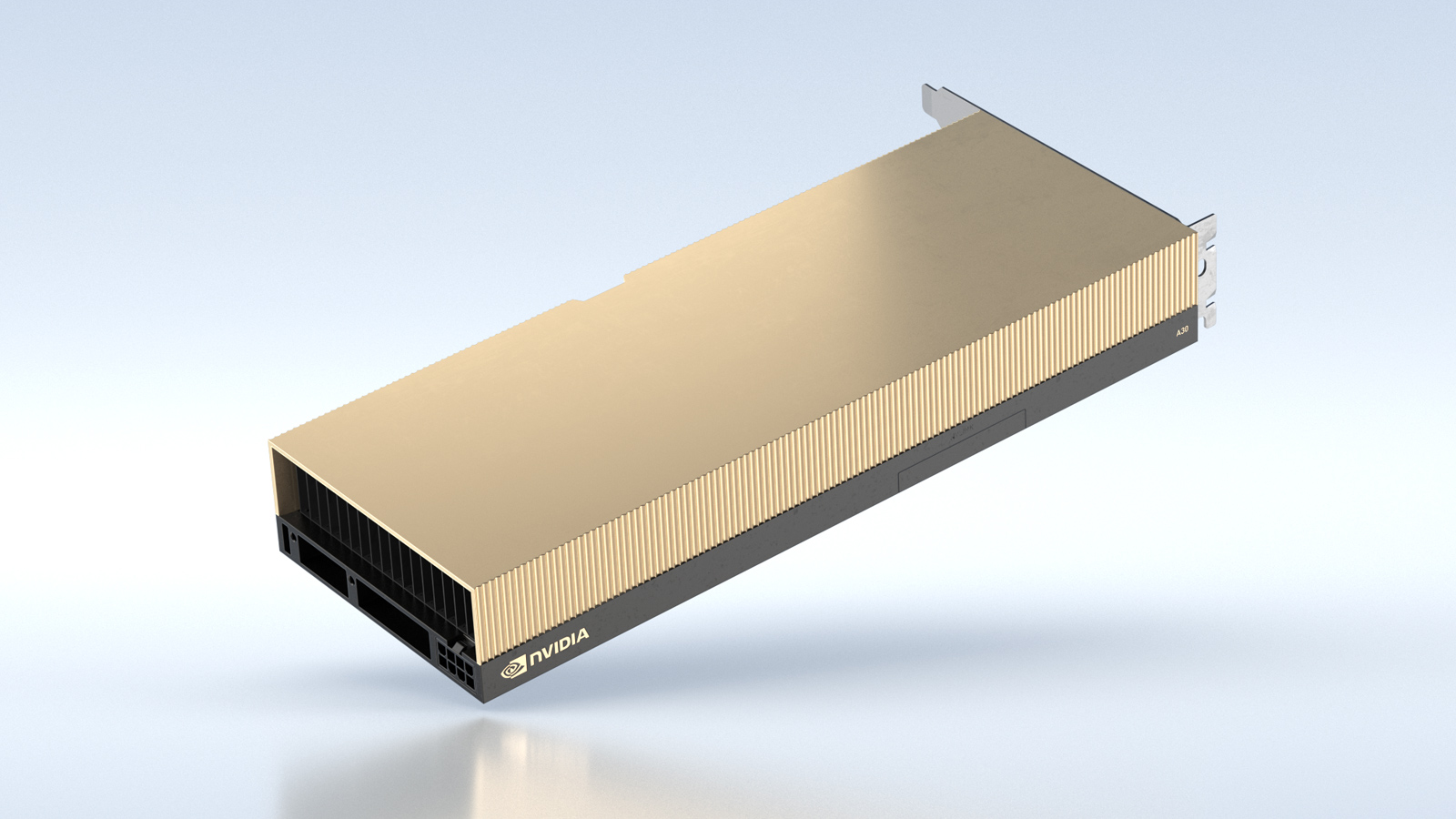

Hoy, la GPU insignia de Nvidia es la Ampere A100, presentada el año pasado. Este es un chip poderoso, ideal para supercomputadoras, computación de alto rendimiento (HPC) y proyectos de inteligencia artificial (IA) a gran escala, pero también es de gran tamaño para algunos casos de uso y presupuestos. . Es por eso que, en GTC 2021, el proveedor presentó dos versiones de su producto estrella A100: el A30, destinado a servidores ordinarios de inteligencia artificial y análisis, y el A10, diseñado para cargas de trabajo. obra mixta (cálculo y renderizado 3D). Estas dos GPU se han diseñado en comparación con la A100, que es más grande, más potente y consume más energía.

Una variación de rango medio del A100, la GPU A30 ofrece la mitad del rendimiento que la primera. (Crédito Nvidia)

El A30, por ejemplo, admite la misma precisión matemática que el A100 para cargas de trabajo de AI y HPC (Floating Point 64 hasta INT4) y partición de GPU de instancias múltiples (MIG), pero ofrece la mitad del rendimiento del A100 con menos memoria y menos núcleos. El A10 también se deriva del A100, pero funciona incluso peor que el A30. Por ejemplo, no admite FP64, solo FP32. Viene equipado con memoria GDDR6 en lugar del HBM2 más rápido y caro del A100. Está diseñado para cargas de trabajo como renderizado 3D, inferencia de IA y codificación de video. Nvidia no ha fijado una fecha de lanzamiento para estas dos tarjetas.

DGX en modo de suscripción

Los principales proveedores de equipos informáticos (Cisco, Dell, HPE, NetApp o incluso Pure Storage) ofrecen una opción de alquiler, era lógico que Nvidia también lo hiciera. El servidor HPC más reciente de la compañía, el DGX Station A100, ahora se puede alquilar por un período corto y luego se puede devolver cuando haya terminado. El programa se conoce oficialmente como Nvidia Financial Solutions (NVFS). Es una sabia decisión. Las empresas no tienen una necesidad constante de supercomputadoras como, por ejemplo, Météo France. En muchos casos, solo necesitarán potencia informática durante un período breve, quizás algunas veces al año. Por tanto, una inversión de varios millones de euros no tiene sentido para equipos que corren el riesgo de quedar infrautilizados. La firma de San José también anunció el DGX SuperPod, que estará disponible con las DPU Bluefield-2, lo que permitirá una supercomputadora "nativa de la nube". Un DGX SuperPod consta de un conjunto de servidores DGX Station en un factor de forma de 4U para montaje en bastidor. Es un superordenador completamente desnudo, al que se debe injertar un entorno operativo, y que también se puede compartir.

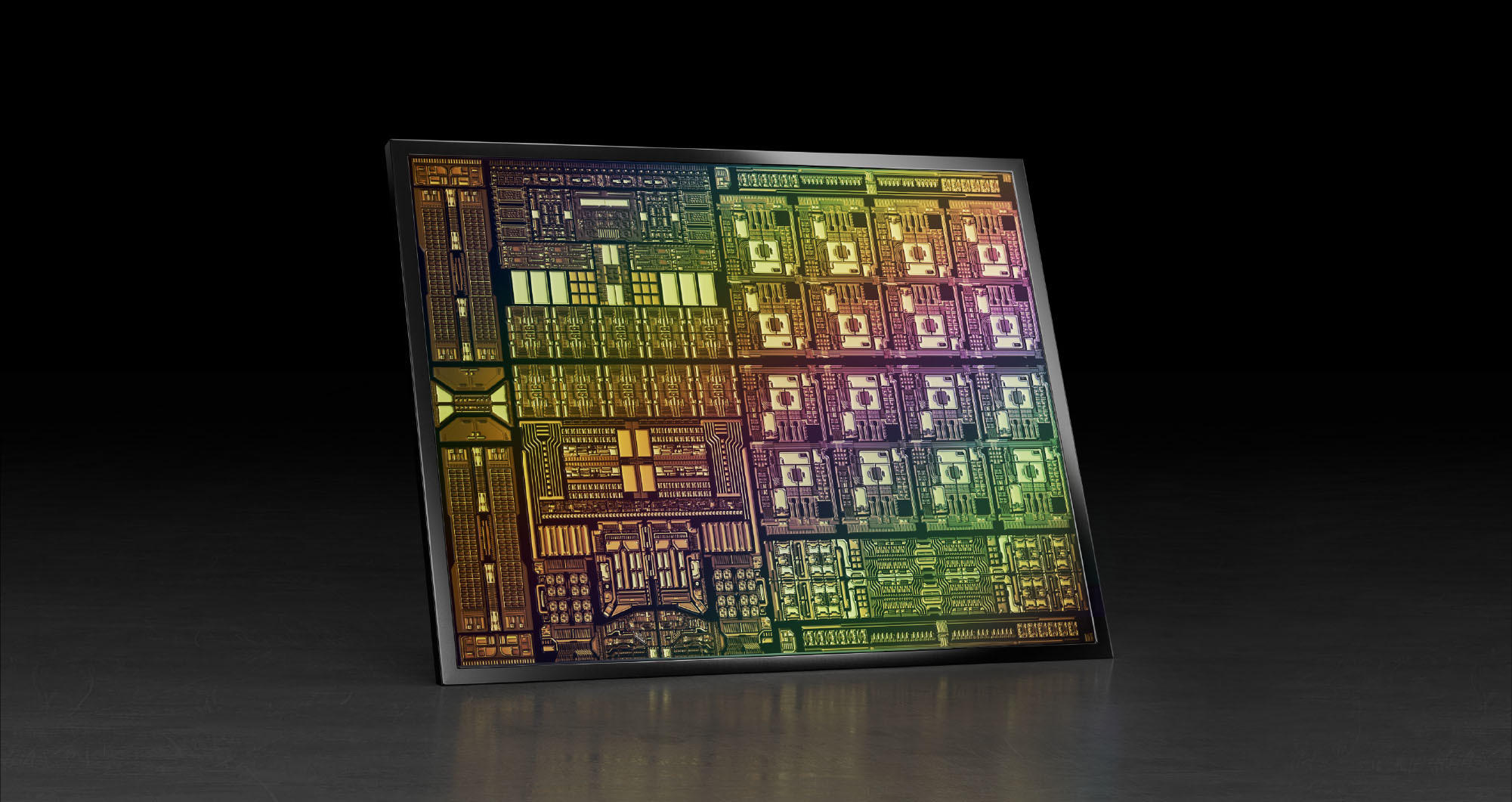

Hoja de ruta de pulgas

Nvidia está lejos de estar inactiva en lo que respecta al desarrollo. El CEO Jen-Hsun Huang presentó una hoja de ruta para los próximos chips (GPU, DPU y CPU), y es muy ambiciosa. Para 2025, el proveedor planea lanzar seis generaciones de hardware: dos para Ampere (GPU), dos para Grace (CPU ARM) y dos para Bluefield (DPU). Ampere Next es el nombre en clave para la próxima generación de GPU, que se espera para 2022. Se especula que el producto comercial se llamará Hopper, continuando la tradición de nombrar las arquitecturas de GPU en honor a los pioneros de la informática. Asociado con la CPU Grace, un sistema Nvidia que asocia un chip ARM y una GPU doméstica podría, por lo tanto, llamarse Grace Hopper, el legendario pionero de la informática en la Marina estadounidense. Ampere Next Next debutará en 2024 o 2025.

Como resultado de la adquisición de Mellanox, el DPU Bluefield-3 se beneficia del movimiento superior de ARM. (Crédito Nvidia)

Grace está programada para 2023 y Grace Next para 2025, mientras que la unidad de procesamiento de datos (DPU) Bluefield heredada de Mellanox también tendrá dos iteraciones: Bluefield-3 en 2022 y Bluefield-4 en 2024. Nvidia hace grandes afirmaciones sobre el rendimiento. Bluefield-3 será 10 veces más rápido que Bluefield-2, y Bluefield-4 podría multiplicar el rendimiento por 100. La DPU BlueField-3, que combina una CPU ARM y un procesador de red para descargar el procesamiento de red de las CPU, cuenta con enlaces de 400 Gbps y cinco veces la potencia de cálculo ARM de la DPU actual. Según Nvidia, una DPU BlueField-3 proporcionaría servicios de centro de datos equivalentes a 300 x86 núcleos.

Uso de tecnología ARM

Si bien Nvidia resuelve los problemas relacionados con la adquisición de ARM propuesta, la compañía está trabajando arduamente para promover la plataforma de CPU en todos los ámbitos. Primero, la firma anunció que proporcionará aceleración de GPU para Graviton2 de Amazon Web Services, el procesador ARM del propio operador de la nube. Las instancias aceleradas de Graviton2 proporcionarán mejores experiencias de transmisión de juegos y reducirán el costo de las poderosas capacidades de inferencia de IA.

En el lado de la fundición, Nvidia está trabajando con MediaTek, una de las principales compañías de chips para teléfonos inteligentes, para crear una categoría de computadoras portátiles con una CPU ARM y una GPU Nvidia RTX. Estas computadoras portátiles utilizarán núcleos ARM y núcleos gráficos Nvidia para proporcionar a los consumidores computadoras portátiles energéticamente eficientes con capacidades multimedia sin concesiones basadas en una plataforma de referencia que admite los SDK de Linux, Chromium y Nvidia. Y en informática de punta, Nvidia está trabajando con Marvell Semiconductor para combinar sus procesadores Octeo ARM con las GPU de Nvidia. Juntos, acelerarán las cargas de trabajo de IA para la automatización y la seguridad de la red.

Si quieres conocer otros artículos parecidos a GTC 2021: Nvidia se centra en el centro de datos puedes visitar la categoría Otros.

Otras noticias que te pueden interesar