Microsoft perfecciona los LLM con GPT-RAG

hace 3 meses

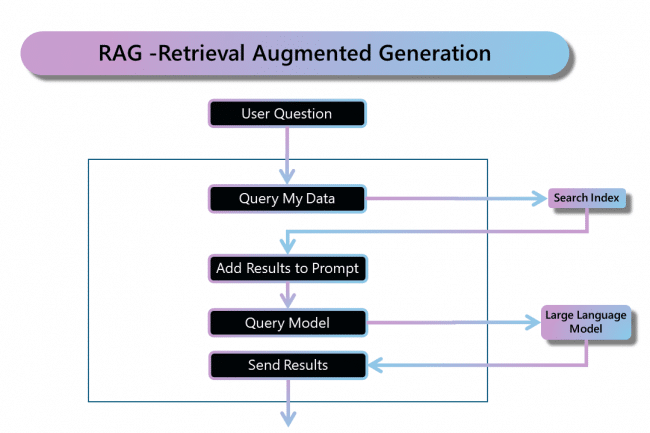

Microsoft ha lanzado GPT-RAG, una biblioteca de aprendizaje automático de vanguardia. Basado en tecnologías de extracción, RAG mejora la implementación de LLM integrando fuentes de datos de la empresa.

Con el auge de la IA, las empresas están adoptando gradualmente modelos de lenguajes grandes (LLM). Sin embargo, la integración de estas herramientas sigue siendo un desafío importante debido a su complejidad y a la necesidad de mantener la gobernanza. En este sentido, Microsoft Azure ha presentado GPT-RAG, una biblioteca para utilizar la tecnología RAG (Retrieval Augmentation Generation) en la nube. Este servicio utiliza “Búsqueda cognitiva para investigación y LLM de Azure OpenAI para impulsar experiencias de tipo ChatGPT y preguntas y respuestas”, especifica Microsoft en la página dedicada de GitHub.

Este acelerador tiene un marco de seguridad sólido y principios de confianza cero para garantizar que los datos confidenciales se manejen adecuadamente. Para ello, GPT-RAG utiliza varias herramientas: Azure Virtual Network, Front Door para WAF (Web Application Firewall), Bastion para el acceso seguro al escritorio remoto y Jumpbox para el acceso a las VM en los subsistemas. redes privadas. Microsoft presenta su herramienta como "ideal para organizaciones que pasan de las fases de exploración y PoC a la producción a gran escala y MVP". Tenga en cuenta también que GPT-RAG ofrece escalamiento automático, adaptabilidad a cargas de trabajo de vanguardia y almacenamiento analítico potencial, incluida la integración de elementos como Cosmos DB. RAG también facilita las actualizaciones periódicas de datos sin necesidad de realizar ajustes, lo que lo convierte en una gran ventaja.

GPT-RAG, un garante confiable para el uso de LLM en los negocios

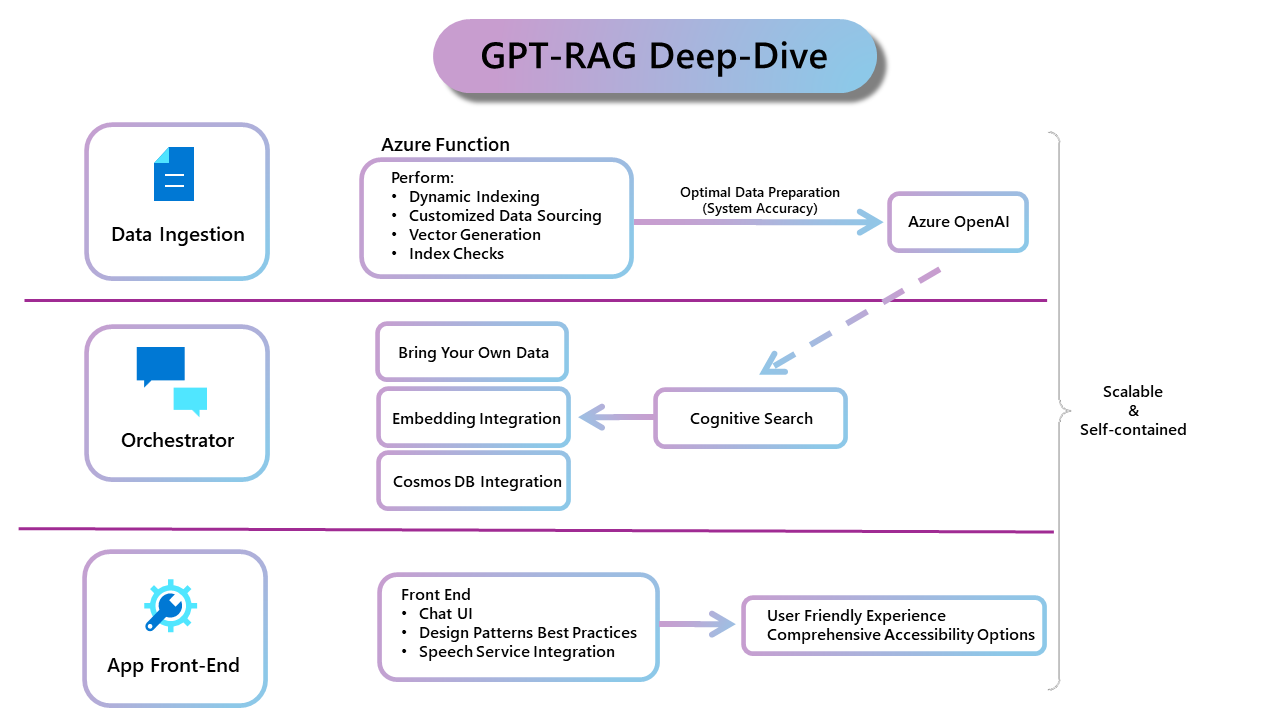

Además, los investigadores del GPT-RAG destacan que cuenta con un completo sistema de observabilidad, garantizando así la optimización del despliegue de los LLM en las empresas. La base de GPT-RAG incluye tres componentes clave: ingesta de datos, un orquestador y una aplicación de interfaz de usuario. La ingesta de datos ayuda a optimizar la preparación de datos para Azure OpenAI, mientras que Orchestrator garantiza la escalabilidad y coherencia de las interacciones de los usuarios. Finalmente, la aplicación front-end, creada con Azure App Services, ofrece una interfaz de usuario fluida y escalable.

Centrarse en la arquitectura GPT-RAG: ingesta de datos, Orchestrator y una interfaz de usuario de "aplicación frontal". (Crédito: Microsoft)

Microsoft agrega que Databricks es uno de sus socios más estratégicos con algunos de los servicios de datos en Azure. Una coinnovación que se refleja en particular en la interoperabilidad de Azure Databricks con Microsoft Fabric, y en la forma en que el primero aprovecha Azure OpenAI para ofrecer experiencias de IA. "Esto significa que los clientes pueden aprovechar los LLM en Azure OpenAI al crear capacidades de IA, como aplicaciones RAG en Azure Databricks, y luego usar Power BI en Fabric para analizar los resultados", afirma la empresa. Finalmente, GPT-RAG demuestra ser una herramienta que garantiza el uso racional de los LLM por parte de las empresas, ayudándolas a integrar e implementar motores de búsqueda, evaluar documentos y crear robots de calidad. Todo con un enfoque en seguridad, escalabilidad, observabilidad e IA responsable.

Si quieres conocer otros artículos parecidos a Microsoft perfecciona los LLM con GPT-RAG puedes visitar la categoría Otros.

Otras noticias que te pueden interesar