Nvidia confía en la refrigeración líquida para sus sistemas HPC

hace 2 años

Para reforzar su negocio de HPC, Nvidia está promocionando cuatro plataformas de referencia con nodos de HPC para tareas exigentes que incluyen capacitación en inteligencia artificial, computación de alto rendimiento, modelado de gemelos digitales y aceleración de gráficos basada en la nube.

Justo antes de Computex (del 24 al 27 de mayo, Taipei, Taiwán) e ISC High Performance (del 29 de mayo al 2 de junio, Hamburgo, Alemania), Nvidia presentó diseños de referencia para computación de alto rendimiento (HPC) y tecnología de refrigeración por agua (una transferencia de calor). fluido de hecho) para sus GPU. Las arquitecturas de referencia explotan la CPU Grace Superchip y el dúo de CPU/GPU Grace Hopper Superchip (ambas basadas en ARM) para centros de datos, previstas para el próximo año. El procesador Grace Superchip combina dos matrices de procesador Grace en un solo circuito, conectado con la tecnología NVLink-C2C de 900 GB/s del proveedor de chips, que proporciona 144 núcleos y garantiza 1 TB/s de ancho de banda de memoria en una huella eléctrica de 500 vatios. Grace Hopper Superchip reemplaza una de las CPU por una GPU H100, también conectada directamente a la CPU por NVLink-C2C, con un consumo de 1000 vatios.

Estos dos chips integrarán la línea de productos HGX de Nvidia para grandes implementaciones de HPC, donde la densidad de cómputo está a la orden del día. Están disponibles en versiones 1U y 2U con dos nodos HGX Grace-Hopper o cuatro nodos HGX Grace en un solo chasis. Los cuatro están equipados con circuitos de red DPU BlueField-3.

Los cuatro modelos comercializados son:

- Sistemas HGX Grace Hopper para aprendizaje, inferencia y supercomputación de IA.

- HGX Grace para supercomputación y supercomputadoras con un diseño solo de CPU

- OVX para potenciar la simulación de gemelos digitales (copias virtuales de objetos físicos) y cargas de trabajo colaborativas.

- Finalmente, CGX para aceleración de gráficos y juegos en modo nube (computación remota)

Las soluciones de Nvidia están disponibles para los usos principales con aceleración GPU para computación intensiva. (Crédito SL)

"Estos nuevos diseños de referencia permitirán que nuestro ecosistema produzca rápidamente servidores optimizados para las pilas de software de computación acelerada de Nvidia, y [ils] puede calificarse como parte de nuestra gama de sistemas certificados por Nvidia”, explicó Paresh Kharya, director de la actividad del centro de datos de Nvidia, durante una rueda de prensa. La firma de Santa Clara ya cuenta con seis socios proveedores que planean lanzar sistemas en la primera mitad del próximo año: Asus, Foxconn, Gigabyte, QCT, Supermicro y Wiwynn.

Refrigeración líquida para GPU

En el frente de refrigeración por agua (líquido de transferencia de calor), Nvidia reconoce lo que los jugadores saben desde hace algún tiempo: sus GPU se calientan mucho y la refrigeración líquida es una alternativa viable a la refrigeración por aire. La GPU actual de la serie 3000 refrigerada por aire de Nvidia tiene un grosor de hasta tres pulgadas. La placa en la que se asienta la GPU tiene solo unos pocos milímetros de grosor, y el disipador de calor y el ventilador marcan la diferencia, lo que los hace extremadamente voluminosos y difíciles de colocar en un espacio reducido. Por lo tanto, Nvidia se inspira en viejas prácticas ya presentes en grandes sistemas: elimina el disipador de calor y el ventilador y los reemplaza con un sistema de refrigeración líquida mucho más delgado, similar a la tecnología de refrigeración por agua utilizada en las CPU. El fluido de transferencia de calor se dirige a través de una tubería para enfriar la placa sobre el procesador, antes de ser succionado para enfriarse.

El resultado es una tarjeta PCIe refrigerada por líquido para la GPU insignia de Nvidia, la Ampere A100, que estará disponible en el tercer trimestre de este año. El proveedor tiene un plan similar para el sucesor del A100 recientemente anunciado, el H100 que aprovecha la arquitectura Hopper y se espera para el próximo año. El bloque con el fluido de transferencia de calor es mucho más delgado que el disipador de calor, lo cual es esencial. Los disipadores de calor son tan grandes que bloquean la ranura PCI Express justo al lado de ellos. Con el bloque de agua, se puede colocar una segunda placa en el chasis. “La refrigeración líquida ha existido desde los días de los mainframes y hoy en día se usa mucho para enfriar las supercomputadoras más rápidas del mundo. Por lo general, admitimos estas implementaciones con nuestras plataformas HDX de alto rendimiento. Sin embargo, hoy en día, incluso los principales centros de datos empresariales están explorando las posibilidades de la refrigeración líquida en su infraestructura”, dijo Kharya.

Agregó que la refrigeración líquida permitirá que estos servidores HPC brinden el mismo nivel de rendimiento que los enfriados por aire mientras consumen hasta un 30% menos de energía, según los resultados de pruebas recientes realizadas por Nvidia. con Equinix. Se espera que más de una docena de fabricantes de servidores admitan la tarjeta PCIe A100 refrigerada por líquido a finales de este año, incluidos ASUS, Gigabyte, Inspur y Supermicro.

Jetson para el borde

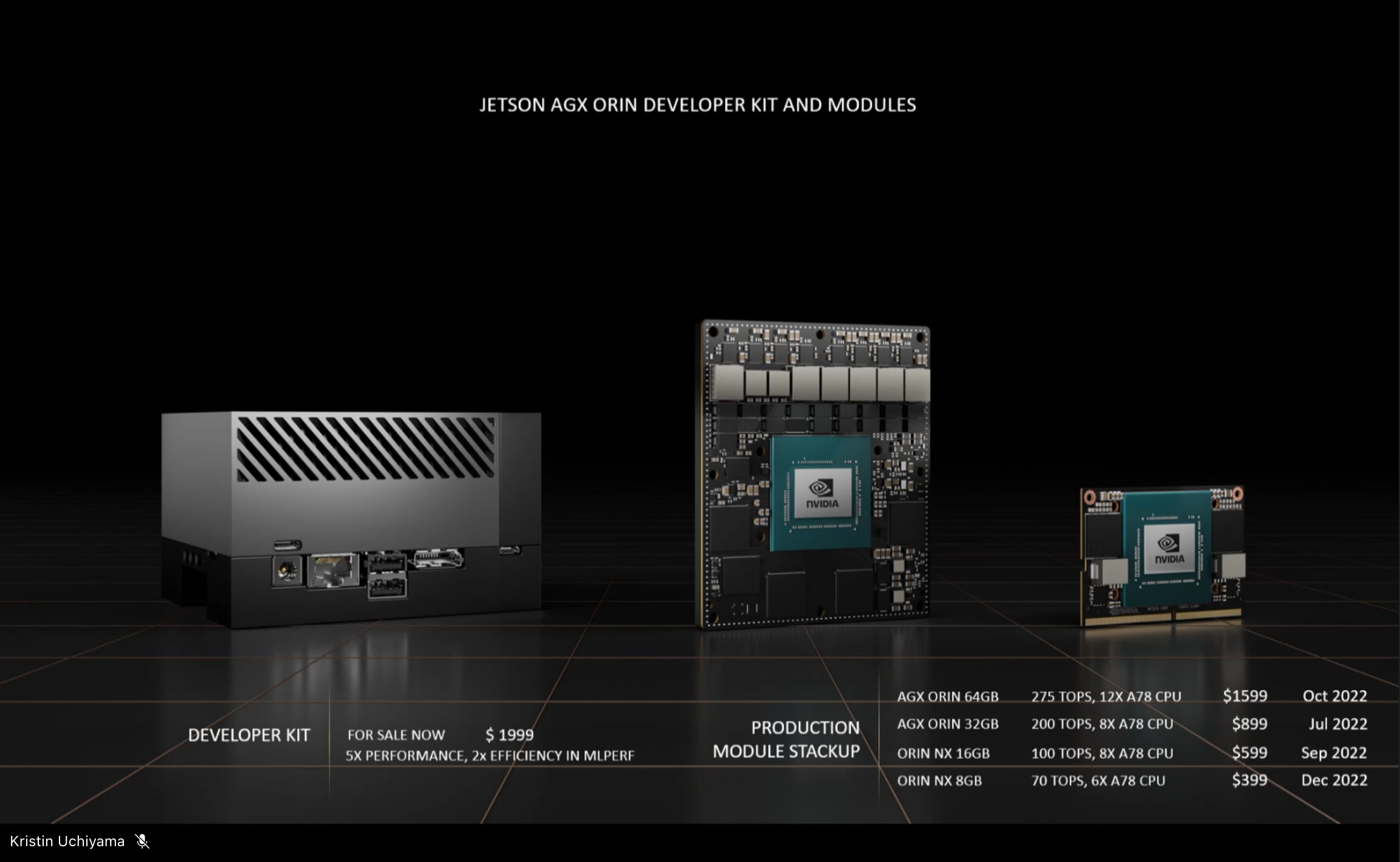

La firma de Santa Clara también anunció una implementación más amplia de su plataforma Jetson AGX Orin de bajo consumo en sistemas ofrecidos por más de dos docenas de socios proveedores. Jetson AGX Orin se anunció a principios de este año en el evento GTC de Nvidia. Este es un kit de desarrollo con una computadora de placa única basada en una CPU ARM con 12 núcleos Cortex-A78AE y una GPU Ampere A100.

Destinado a usos periféricos e integrados, Jetson se basa en un chip de bajo consumo compatible con una potente GPU equipada con aceleradores para el procesamiento de IA. (Crédito SL)

Nvidia dice que 6000 clientes en todo el mundo están creando soluciones con chips Jetson y, para satisfacer la creciente demanda, el proveedor ha anunciado cuatro modelos de referencia con diferentes configuraciones de memoria, disponibles a finales de este año.

Si quieres conocer otros artículos parecidos a Nvidia confía en la refrigeración líquida para sus sistemas HPC puedes visitar la categoría Otros.

Otras noticias que te pueden interesar