Nvidia renueva con Intel para su DGX H100

hace 1 año

Esperados desde hace varios meses, los chips Intel Xeon Scalable de cuarta generación están llegando a los servidores y arreglos de almacenamiento de los principales proveedores. Proporcionan aceleradores activables y seguridad mejorada para máquinas virtuales.

Dell, Cisco, HPE, Lenovo, Nvidia y otros han comenzado a exhibir sus equipos con los últimos procesadores Xeon (Sapphire Rapids) de Intel. Este último presentó oficialmente sus procesadores de servidor de cuarta generación, así como las GPU de la serie Max. Realmente no había más secretos ya que el fundador había estado destilando información a la prensa -bajo embargo- durante varias semanas. Entre las características propuestas por Intel, volvamos al aislamiento de máquinas virtuales (VM) con un servicio para verificar su integridad. Llamado Intel Trust Domain Extension (TDX), este servicio protege los datos dentro de un entorno de ejecución confiable (TEE) en la máquina virtual. Basado en el motor Software Guard Extensions (SGX) de Intel, compite con la virtualización cifrada de AMD en el sentido de que proporciona cifrado en tiempo real y protección del contenido de la máquina virtual. Además, Intel también está promocionando su Proyecto Amber, un servicio de verificación multinube SaaS para ayudar a las empresas a verificar TEE, dispositivos y enlaces confiables. Project Amber se lanzará a finales de este año.

Aceleradores bajo demanda

La fundición de Santa Clara también proporcionó más información sobre su servicio Intel On Demand. Los últimos Xeon Scalables vienen con motores de procesamiento especializados, pero requieren una licencia opcional para activarse. El servicio incluye una API para el pedido de licencias y un agente de software para el aprovisionamiento de licencias y la activación de funciones en la CPU. Los clientes tienen la opción de comprar las funciones bajo demanda en el momento de la compra o posteriormente como una actualización. Intel está trabajando con algunos socios para implementar un modelo a la carta donde las funciones bajo demanda se pueden activar y desactivar según sea necesario. El pago se basa en el tiempo de uso en lugar de un modelo de licencia perpetua.

Una IA ahora omnipresente

Durante mucho tiempo se ha aceptado que las cargas de trabajo de inteligencia artificial y aprendizaje automático funcionan mejor en una GPU, pero Intel quiere que la CPU sea igual a la GPU, a pesar de que está comercializando su propia GPU para centros de datos. Los procesadores Xeon Sapphire Rapids se envían con una serie de aceleradores, e Intel está lanzando un conjunto de herramientas de software llamado AI Software Suite que proporciona herramientas comerciales y de código abierto para ayudar a construir, implementar y optimizar las cargas de trabajo de IA. Un elemento clave de estos Xeons es la integración del conjunto de instrucciones Advanced Matrix Extensions (AMX), que, según Intel, puede aumentar el rendimiento de la inferencia de IA en comparación con los Xeons de tercera generación (Ice Lake). El fundador, por ejemplo, especificó que la inferencia en tiempo real y el rendimiento de entrenamiento de PyTorch mejoraron significativamente con los últimos Xeons.

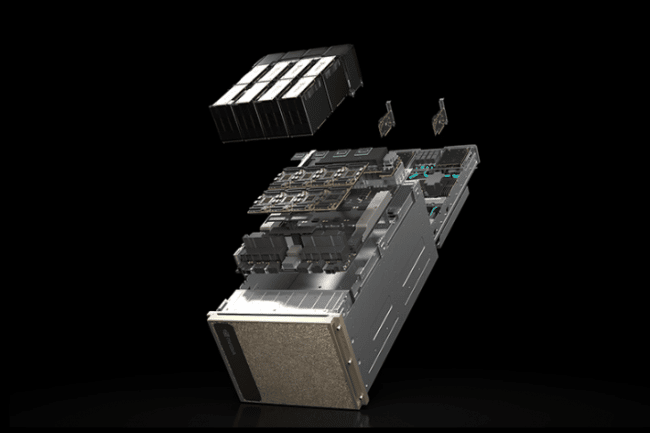

Los sistemas DGX H100 pueden unirse para formar un DGX SuperPod listo para usar que ofrece hasta un nivel de rendimiento para el procesamiento de IA. (Crédito Nvidia)

Los DGX están de vuelta en la carrera de HPC con Intel

Si proveedores como Dell, HPE, Lenovo o Supermicro han anunciado, como era de esperar, la renovación de sus gamas de servidores con los últimos chips Xeon de cuarta generación, el regreso de Nvidia es una buena venganza para Intel. Las relaciones son definitivamente más cordiales entre las dos compañías: recordemos que para su generación anterior de servidores DGX A100, Nvidia prefirió trabajar con chips Epyc 7742 Rome de AMD (128 núcleos Zen 3) para soportar sus cuatro aceleradores A100. Por lo tanto, el DGX H100 se basa en un par de procesadores Xeon Sapphire Rapids (56 núcleos) con hasta ocho placas Tensor Core H100. Nvidia y sus socios (en Asus, Atos, Cisco, Dell, Fujitsu, Gigabyte, HPE, Lenovo, QCT y Supermicro) planean comercializar alrededor de sesenta modelos equipados con GPU Xeon Scalable y H100 con diferentes opciones de almacenamiento flash (Pure Storage, DDN o incluso Panasas).

Según Nvidia, estos sistemas ejecutarán cargas de trabajo en promedio 25 veces más eficientemente que los servidores tradicionales solo de CPU. En comparación con los sistemas acelerados de la generación anterior, los DGX H100 aceleran el aprendizaje y la inferencia para ofrecer 3,5 veces más eficiencia energética. Estos servidores también están equipados con tarjetas de red ConnectX-7 de Nvidia. En total, esta arquitectura ofrece hasta nueve veces mejor rendimiento que la generación anterior y entre 20 y 40 veces mejor rendimiento para el aprendizaje automático y las cargas de trabajo de HPC que los servidores x86 de doble socket sin aceleradores.

Si quieres conocer otros artículos parecidos a Nvidia renueva con Intel para su DGX H100 puedes visitar la categoría Otros.

Otras noticias que te pueden interesar