Todo lo que salió mal con el algoritmo fallido de A-Levels

hace 4 años

El 18 de marzo, el gobierno anunció que, como tantas instituciones anuales que han sido víctimas de Covid-19, los exámenes de este verano serían cancelados.

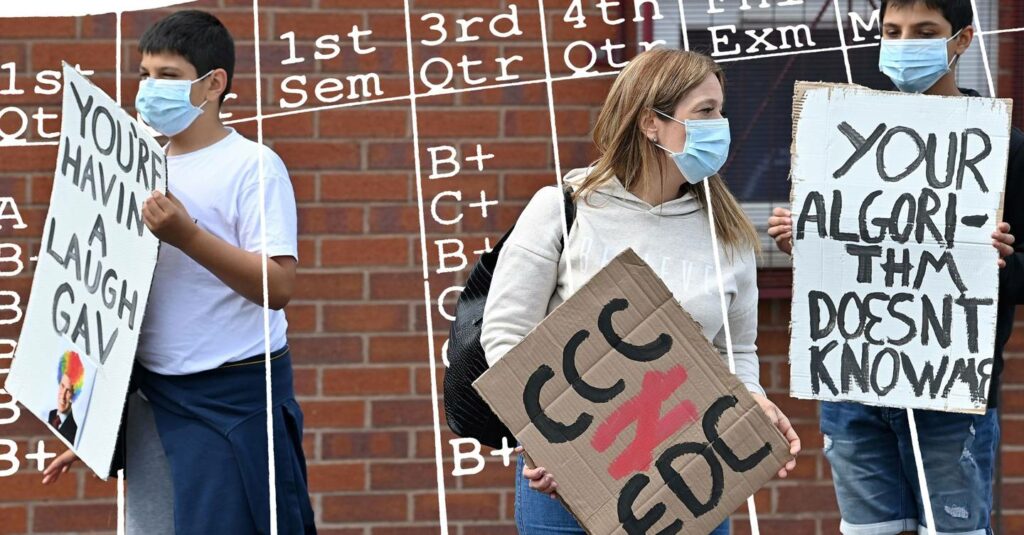

En lugar de los exámenes, la Oficina de Regulación de Calificaciones y Exámenes (Ofqual) pidió a los maestros que pronosticaran las calificaciones que habría obtenido cada uno de sus estudiantes. Dado que los profesores tienden a ser optimistas sobre el rendimiento de sus alumnos (tienden a predecir su resultado "en un buen día"), se consideró necesario un mayor refinamiento para no socavar los sextos cursos ", universidades", y empleadores & # 39; confianza en los resultados de este año. Aquí es donde intervino el ahora muy difamado algoritmo de Ofqual, como un amortiguador de este optimismo.

Ofqual afirmó que si esta estandarización no se hubiera llevado a cabo, habríamos visto el porcentaje de calificaciones A * en los niveles A subir del 7.7 por ciento de las calificaciones en 2019 al 13.9 por ciento de las calificaciones de este año. Pero después de que el algoritmo rebajó el 39 por ciento de las calificaciones de nivel A pronosticadas por los maestros en Inglaterra, el gobierno ha efectuado un cambio total. El algoritmo se ha abandonado y los estudiantes serán calificados tardíamente con las predicciones del maestro original. Entonces, ¿cómo funcionó el algoritmo? ¿Y qué salió mal?

El modelo fue extremadamente complicado. (Jeni Tennison, vicepresidenta del Open Data Institute, lo desglosa en detalle aquí). En primer lugar, Ofqual creó un perfil histórico de las calificaciones que los alumnos habían obtenido anteriormente para cada materia ofrecida en cada escuela; por ejemplo, para los resultados de nivel A, examinó los resultados de los últimos tres años por materia. Luego examinó cómo esas calificaciones se relacionaban con su calificación final en esas materias cada año.

Luego, Ofqual generó tres conjuntos de calificaciones: la distribución real de las calificaciones de años anteriores, la distribución prevista de las calificaciones de los estudiantes anteriores y luego la distribución prevista de las calificaciones de los estudiantes actuales. Ambas distribuciones previstas se basan en lo que se logró a nivel nacional en cada materia, en años anteriores, por niños con logros anteriores similares (GCSE para los resultados de A Level o Key Stage 2 para GCSE).

El algoritmo calculó la diferencia entre la distribución predicha para los estudiantes actuales y los estudiantes anteriores, y usa esto para ajustar la distribución real de los estudiantes anteriores para dar una distribución para los estudiantes actuales.

Después de esto, a los estudiantes se les asignó sus calificaciones según una clasificación proporcionada por los maestros de todos los estudiantes en una cohorte, de mejor a peor. Ofqual describió el razonamiento detrás de esto en un informe de 317 páginas, diciendo que las personas son mejores para hacer juicios relativos que absolutos. Los maestros, dice el informe, serían más precisos al clasificar a los estudiantes en lugar de estimar sus logros futuros.

"Eso le da calificaciones aproximadas para cada estudiante", dice Tennison. "A partir de esas calificaciones, trabajan hacia atrás hasta las calificaciones que podrían haber obtenido en el examen". El sistema de clasificación significaba que incluso si se le pronosticó una B, si se clasificó en el decimoquinto lugar en su clase y el alumno en el decimoquinto en los últimos tres años recibió una C, es probable que obtenga una C.

Aunque la proporción de calificaciones A se elevó a un máximo histórico del 27,9 por ciento, el algoritmo, y aquí es donde radica la controversia, también rebajó casi el 40 por ciento de las calificaciones de nivel A pronosticadas por los profesores en Inglaterra.

Hubo varios problemas con este proceso. La primera fue que el uso de un promedio nacional de calificaciones penalizaba a las escuelas excelentes. “Si una escuela tiende a hacerlo muy bien, en el sentido de que obtiene los mejores resultados posibles de A-Level, no solo para los estudiantes que obtienen una puntuación excepcionalmente buena en GCSE, sino también para los estudiantes que obtienen una puntuación baja en GCSE, entonces ese tipo de escuela será penalizada por este modelo, simplemente porque la escuela promedio no lo hace tan bien ”, dice George Constantinides, profesor de computación digital en el Imperial College.

También hubo un problema con el tamaño de las cohortes: estos no son exactamente los mismos que los tamaños de las clases (una escuela privada puede tener muchas clases pequeñas pero aún ingresar suficientes alumnos para una cohorte grande) pero, debido a la falta de datos, una cohorte que los promediados menores de cinco solo recibieron las predicciones de su maestro. “Hemos visto que a las escuelas independientes les ha ido bastante bien con esto porque tienden a ser más pequeñas que las escuelas estatales y, con mayor frecuencia, tienen un número menor de alumnos”, dice Philip Nye, gerente de asuntos externos de FFT Education Datalab. un grupo de expertos en políticas educativas. “En algunos temas como los idiomas y la música, estamos viendo resultados absolutamente disparados. Porque estos suelen ser ingresados por solo unos pocos estudiantes en cada escuela. "

Otro problema con el sistema estaba relacionado con las pruebas. Con el fin de probar la precisión del modelo, dice Constantinides, Ofqual miró hacia atrás en una ventana de tiempo similar e intentó usarla para ver si predecía adecuadamente los resultados de 2019. Esto no fue tan exitoso: para algunos sujetos, el modelo tenía solo un 40% de precisión en términos de predecir lo que realmente logró la cohorte de 2019. Peor aún: esta precisión se basó en la clasificación de dónde llegaron realmente los estudiantes de 2019 en su cohorte según los resultados de sus exámenes. La clasificación de 2020 fue solo una predicción hecha por los maestros.

“(Esta prueba) asumió un orden de clasificación perfecto para ver qué tan bien se comporta el modelo”, dice Constantinides. "Entonces, cuando Ofqual dice que su modelo tiene una precisión del 40%, es probable que sea mucho menos que eso, porque eso no tiene en cuenta ninguna inexactitud en el orden de clasificación".

Muchos de estos problemas podrían haberse resuelto antes del día de los resultados, si hubiera habido una consulta y transparencia adecuadas. "Creo que todavía hay preguntas sin respuesta: las escuelas todavía se están rascando la cabeza sobre cómo se obtuvieron exactamente sus resultados, lo cual no es justo", dice Constantinides.

El modelo podría haberse publicado antes de los resultados, y los expertos podrían haberlo monitoreado y analizado. Sky News informó que la Royal Statistical Society se ofreció a ayudar al regulador con el algoritmo en abril, escribiendo a Ofqual para sugerirle que tomara el consejo de expertos externos.

“Habría ayudado a incluir las voces de los padres y los niños en las universidades y los maestros, y de los especialistas y expertos en educación y los estadísticos y científicos de datos en todo ese proceso”, dice Tennison. "Parte del problema aquí es que estos problemas surgieron solo después de que se les dieron las calificaciones a los estudiantes, cuando podríamos haber tenido estas discusiones y examinar el algoritmo y comprender las implicaciones de él mucho, mucho antes". Tampoco existía un mecanismo de rectificación claro para ahorrar ansiedad, tiempo y dinero a las personas, a pesar de que la toma de decisiones automatizada siempre comete errores.

Ahora, los estudiantes recibirán las calificaciones previstas por su maestro. Aunque esta es sin duda la peor alternativa, viene con las mismas preocupaciones que Ofqual estaba tratando de mitigar: las calificaciones altas serán injustas en las cohortes posteriores, las calificaciones altas de escuelas específicas serán injustas en otras escuelas, y los de sexto grado, universidades y Los empleadores pueden terminar tomando los resultados de este año con una pizca de sal. "Un algoritmo en sí mismo no es ni bueno ni malo", dice Nye. "Son los efectos que tiene y la forma en que se ha configurado".

El cambio de sentido en sí mismo también es un desastre potencial. Más allá del estrés que ha infligido a los estudiantes, el gobierno esencialmente ha pasado la pelota administrativa a las universidades, que ahora tendrán que considerar honrar miles de ofertas más; han dicho que a pesar del cambio de sentido, no será posible cumplir con todas las ofertas originales. . (Ofqual no respondió a una solicitud de comentarios en el momento de la publicación).

“Toda esta historia realmente ha resaltado los problemas que existen en torno a la toma de decisiones automatizada, en particular cuando es implementada por el sector público”, dice Tennison. “Esto ha aparecido en los titulares porque afecta a mucha gente en todo el país y afecta a las personas que tienen voz. Hay otras tomas de decisiones automatizadas que ocurren todo el tiempo, por ejemplo, en torno a los beneficios que afectan a muchas personas que no tienen esta voz fuerte. "

Will Bedingfield es redactor de Mundo Informático. El tuitea desde @WillBedingfield

Más historias geniales de Mundo Informático

? Los trenes nocturnos son geniales. Entonces, ¿por qué el Reino Unido no tiene ninguno para Europa?

? Ha comenzado la carrera para crear una vacuna. Esta vacuna de ARNm contra el coronavirus es dos avances en uno

? ¿Necesitas un poco de paz? Estos son los mejores auriculares con cancelación de ruido en 2020

? Escuche The Mundo Informático Podcast, la semana de ciencia, tecnología y cultura, que se entrega todos los viernes

? Siga Mundo Informático en Gorjeo, Instagram, Facebook y LinkedIn

Si quieres conocer otros artículos parecidos a Todo lo que salió mal con el algoritmo fallido de A-Levels puedes visitar la categoría Otros.

Otras noticias que te pueden interesar