Kubecon 2024: CNCF ve a Kubernetes como estándar para la IA

hace 44 mins

Desde la inauguración de Kubecon, que tuvo lugar en París (del 20 al 23 de marzo), el CNCF centró claramente su discurso en torno a la IA. Los clientes tienen grandes expectativas, particularmente en lo que respecta a las contribuciones de los entornos Kubernetes a la optimización de las plataformas de IA.

Toda la comunidad nativa de la nube se reunió en Porte de Versailles en París para Kubecon. Organizada por la CNCF (fundación de computación nativa en la nube), esta edición europea que se celebra actualmente en la capital (del 20 al 23 de marzo) prevé acoger a 12.000 personas durante 3 días. Priyanka Sharma, directora general de la CNCF, inauguró el evento centrado en la inteligencia artificial. “Estamos construyendo las infraestructuras del mañana”, explica en el preámbulo, al tiempo que subraya que Kubernetes, el organizador de los clusters de contenedores, celebra este año (el próximo junio) su décimo aniversario.

Aborda los desafíos que enfrentan las empresas con la IA hoy en día: “crear prototipos es fácil, pero ponerlos en producción es complicado. Además, existen muchas preocupaciones en torno a los costes”. Según ella, hay que evitar la “exuberancia obsesiva”, para utilizar una famosa frase de Alan Greenspan, ex director de la Reserva Federal estadounidense. Para ello, “es necesaria una estandarización que garantice la interoperabilidad, la seguridad, la gestión de costes y recursos, las métricas y las cuestiones éticas sobre los tratamientos de la IA”. Y, obviamente, la CNCF es la cuna ideal para ello.

Altas expectativas en la optimización de recursos

La organización se ha puesto en marcha con varias iniciativas, empezando por un grupo de trabajo dedicado a la IA. Creada el pasado mes de octubre, esta estructura acaba de publicar un libro blanco que enumera los desafíos y las soluciones más modernas en materia de IA. Y los desafíos son múltiples, como lo demuestra una mesa redonda en la que participaron Timothée Lacroix, uno de los cofundadores de Mistral, y Page Bailey, director de producto principal de Google Deepmind. Este último mencionó el problema de la asignación de recursos “con modelos de diferentes tamaños que implican infraestructuras adaptadas, pero también bibliotecas y marcos”. A este respecto, el líder francés favorece “la herramienta Slurm [NDLR : une solution open source qui décrit une demande d'allocation de ressources pour l'exécution d'un traitement] para gestionar la asignación de nodos en Kubernetes para inferencia y ajuste fino.

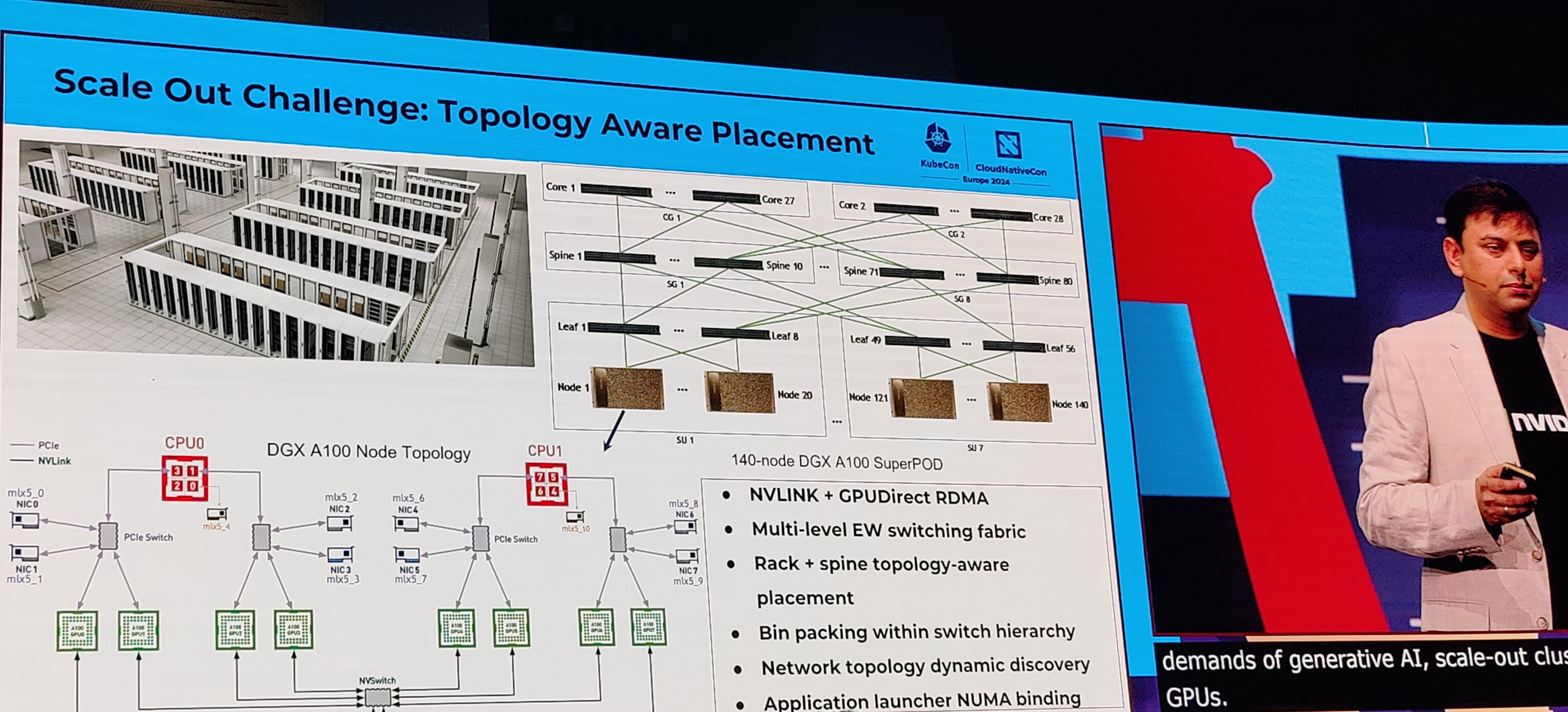

Nvidia presentó sus avances en optimización de recursos en el servicio de generación de imágenes Picasso. (Crédito de la foto: JC)

Nvidia también abordó esta cuestión de la asignación de recursos, en particular la GPU. Kevin Klues, ingeniero principal de software y Sanjay Chatterjee, ingeniero senior, compartieron los avances de la firma en esta área a través del servicio Picasso para crear aplicaciones generadoras de contenido visual. Basados en Kubernetes, han desarrollado diferentes capacidades para optimizar ciertos puntos. “Tuvimos 3 desafíos. El primero fue adaptar la topología de red de nodos, el segundo estaba relacionado con la tolerancia a fallas con necesidades de detección, diagnóstico y automatización para la observabilidad en la infraestructura de GPU. Finalmente, era necesario optimizar el aspecto multidimensional de los modelos y marcos”. Problemas compartidos por el CERN, como lo subraya Ricardo Rocha, ingeniero del centro de estudios, pero también miembro del consejo técnico de la CNCF, “puede haber una subutilización de las GPU y nos inspiramos en cosas existentes en HPC sobre colas, primitivas de programación. Pero necesitamos mejores herramientas para comprender las necesidades de capacidad, el flujo de datos y la optimización del almacenamiento”.

La IA tomada en cuenta en los proyectos

Como podemos ver, hay muchas expectativas y la CNCF tendrá que alinear sus proyectos con la IA. "Kubernetes debe convertirse en el estándar para la IA", afirma Priyanka Sharma. Ya hay varios proyectos en marcha para integrar este componente. Este es el caso de OpenTelemetry, el marco de observabilidad de código abierto que permite a los desarrolladores generar, procesar y transmitir datos telemétricos en un formato único y unificado, ha incluido métricas vinculadas a la IA y el LLM. La iniciativa, sin embargo, no dio detalles ni un calendario para las primeras representaciones.

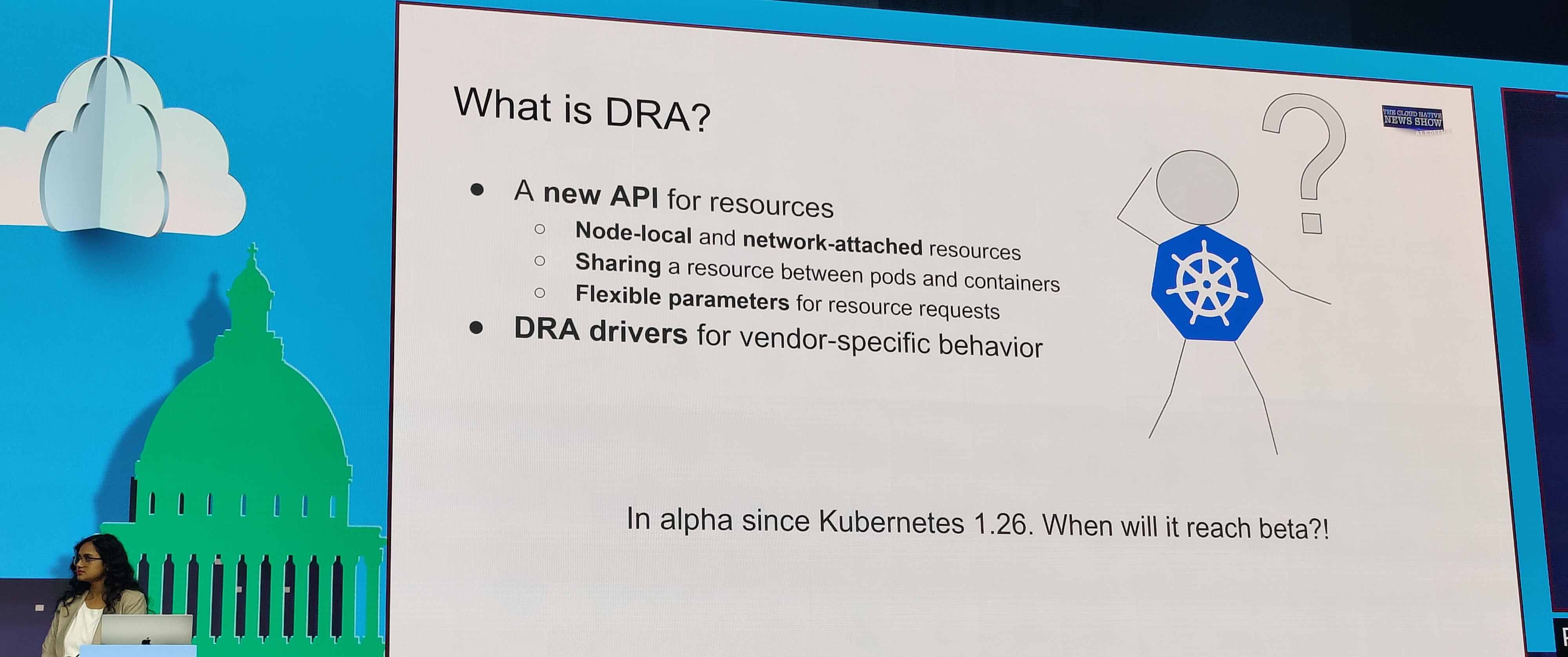

DRA es una respuesta al problema de la gestión de recursos de GPU con una API dedicada en Kubernetes. (Crédito de la foto: JC)

Por su parte, Patrick Ohly, arquitecto de software en la nube de Intel subió al escenario para hablar sobre el proyecto DRA (Dynamic Resource Allocation). Se trata de una API capaz de mejorar las capacidades de Kubernetes para gestionar recursos locales como la CPU o la memoria y también y especialmente las GPU. Ahora en alfa, la API describe los recursos de hardware que necesita un pod para admitir aceleradores complejos. Por lo tanto, en todo el ecosistema CNCF las cosas están progresando en términos de tener en cuenta la IA, pero en los pasillos de la feria, la mayoría de los expositores destacaban el aspecto "legacy" de Kubernetes...

Si quieres conocer otros artículos parecidos a Kubecon 2024: CNCF ve a Kubernetes como estándar para la IA puedes visitar la categoría Otros.

Otras noticias que te pueden interesar