OpenELM, un SLM de código abierto de Apple

hace 40 mins

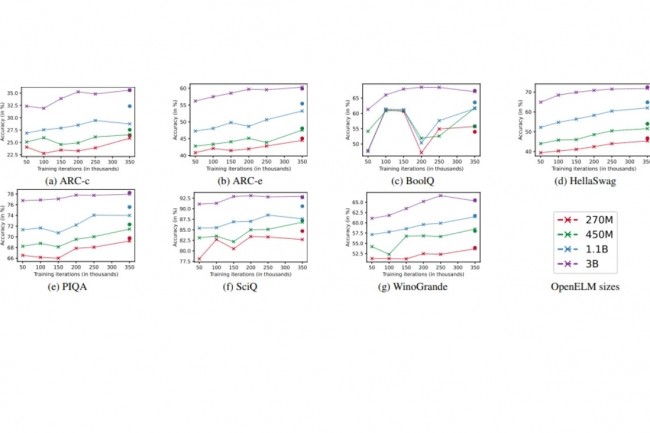

Después de presentar su LLM Ferret en diciembre pasado, Apple anuncia esta vez un modelo de lenguaje pequeño también de código abierto llamado OpenELM. Disponible en cuatro tamaños, desde 270 millones hasta poco más de 3 mil millones de parámetros, la versión 1.1B sería ligeramente más eficiente que OLMo pero más lenta de ejecutar.

No pasa un día sin que las noticias estén salpicadas de anuncios sobre los LLM. Pero también los SLM, modelos de lenguaje que se diferencian de los primeros por sus tamaños más modestos. Justo después de que Microsoft levantara el velo sobre el Phi-3 Mini capaz de funcionar en smartphones (y Orca-Math en marzo), es el turno de Apple de salir del bosque en este nicho lanzando OpenELM. No es la primera vez que la empresa Apple se interesa por el tema de los modelos lingüísticos: en diciembre pasado impulsó, en colaboración con la Universidad de Cornell, un LLM también de código abierto llamado Ferret pero disponible sólo en un marco de investigación. Mientras que este último podría alcanzar hasta 13 mil millones de parámetros, OpenELM no juega en la misma liga con 4 versiones más pequeñas: 270 M, 450 M, 1.08 B y 3.04 B.

"OpenELM utiliza una estrategia de escalado por capas para asignar parámetros de manera eficiente dentro de cada capa del modelo del transformador, mejorando así la precisión", explica Apple en un artículo de investigación. . Para ilustrar su punto, el grupo argumenta, por ejemplo, que OpenELM 1.1 B presenta una mejora del 2,36% en precisión en comparación con OLMo, mientras que requiere la mitad de parámetros en comparación con este último y requiere 2 veces menos de tokens de preentrenamiento. OLMo fue desarrollado por Ai2, una organización sin fines de lucro creada en 2014 por un tal Paul Allen, cofundador de Microsoft con Bill Gates. Este no es el único modelo con el que Apple compara OpenELM, ya que también encontramos en su benchmark OPT (Meta AI), MobiLlama y TinyLlama (derivados de código abierto de Llama de Meta), Pythia (EleutherAI), OpenLM (Apache LangChain) y Cerebras. -GPT (Cerebras).

Trabajar para mejorar la velocidad de ejecución.

Sin embargo, las prestaciones de este modelo en comparación con su competidor parecen sufrir un revés por el momento: "A pesar de la mayor precisión de OpenELM para un número similar de parámetros, observamos que es más lento que OLMo", afirma Apple. Aunque el objetivo principal del estudio de la firma estadounidense está más interesado en la reproducibilidad que en el rendimiento de la inferencia, se llevó a cabo un análisis para comprender este pobre rendimiento.

En su próximo trabajo, Apple planea “explorar estrategias de optimización para mejorar la eficiencia de la inferencia OpenELM, lo que implicará una mejor implementación de RMS Norm (Normalización de capa cuadrática media)”. Este último regulariza la suma de las entradas de una neurona en una capa según la raíz cuadrática media (RMS).

Si quieres conocer otros artículos parecidos a OpenELM, un SLM de código abierto de Apple puedes visitar la categoría Otros.

Otras noticias que te pueden interesar